Es ist eine Weile her seit ihr von mir etwas gehört habt. Entschuldigung.

Dafür geht es gleich mit etwas Großem weiter. Rückblickend wird es sich zeigen, ob hier ein historisches Ereignis in der Datenmodellierungsszene stattfindet: das erste weltweite Treffen (20.3.14 - 22.3.14) von Data Vault Interessierten in der Heimatstatt von Daniel Linstedt, in St. Albans, USA.

Dieses Buch ist ein MUSS für alle, die an Data Vault interessiert sind und auch für alle die sich für Business Intelligence und (Enterprise) Data Warehouse begeistern.

Es ist aus meiner Sicht toll geschrieben: leicht verständlich und es sind alle Themen rund um Data Vault sehr gut erklärt.

Bei einem Kunden hatte ich eine spannende Diskussion über die Frage woher eigentlich Data Vault kommt. Woher im Sinne von: Ist es vom Himmel gefallen oder wurde Data Vault aus anderen Modellierungsarten abgeleitet. Ein naheliegender Gedanke ist, dass Data Vault aus dem Anchor Modeling entstanden ist. Nein, das nicht. Anchor Modeling wurde zum ersten Mal in einem Data Warehouse im Jahr 2004 bei einer Versicherung eingesetzt. Dazu aber später ein anderer Blogpost.

Wie bereits beschrieben, hat Dan Linstedt in den 90ern des letzten Jahrhunderts Data Vault erfunden, daran geforscht und es entwickelt. Bis zur Veröffentlichung im Jahr 2001 hat er rund zehn Jahre seiner Zeit in diese Modellierungsmethode investiert.

Daniel Linstedt veröffentlicht nach und nach was in Data Vault 2.0 an Neuem dazu kommt. Ich möchte euch hier einen Überblick geben, was der aktuelle Stand ist und für euch die Entwicklung weiter verfolgen.

Daniel Linstedt hat auf LinkedIn eine knappe Zusammenfassung gepostet, die ich euch hier wiedergeben möchte.

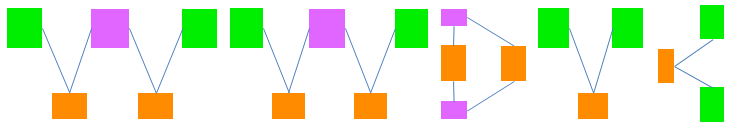

Data Vault 2.0 geht weit über Data Vault 1.0 hinaus. War Data Vault 1.0 auf die Modellierung fokussiert, betrachtet Data Vault 2.0 auch die Architektur, die agile Vorgehensweise bei der Implementierung, vertieft die Performanceaspekte des Data Vault und integriert Technologien wie Hadoop:

Seite 4 von 6